【学术科研】陈熙霖、闵越聪团队荣获ICCV连续手语识别竞赛冠军

近日,ICCV 2025多模态连续手语识别竞赛(The First Multimodal Sign Language Recognition Challenge,MSLR)公布榜单,中国科学院计算技术研究所(以下简称“计算所”)陈熙霖、闵越聪带领的团队(成员包括:杨一帆、焦培淇和南子皙)获得连续手语识别赛道“非特定人识别”和“未见语句识别”两个任务的冠军。该团队长期深耕于手语识别领域,这是继今年早些时候在WWW 2025 跨视角手语孤立词识别竞赛中获得了基于RGB和RGB-D模态输入两个任务第一之后再次夺冠。

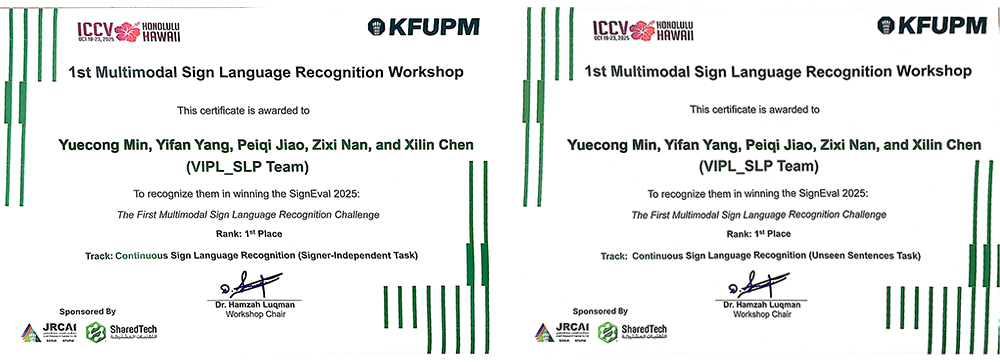

闵越聪助理研究员领取比赛证书

ICCV 2025 MSLR聚焦于多模态场景下的连续手语识别,旨在推动从单一视觉模态(如RGB视频)向融合姿态、雷达、深度等多模态的识别系统转变。针对真实应用中手语交流所面临的实际挑战,连续手语识别竞赛设置了非特定人识别与未见语句识别两个任务,以促进模型在跨手语者与跨语义结构泛化能力方面的提升。该团队在前期提出的VAC、CoSign等连续手语识别方法基础上,进一步引入跨语种预训练与动静态信息融合等方法,有效增强了模型的鲁棒性与泛化能力。最终,团队所提出方法以字错误率(WER)绝对值低于第二名2.2%和19.58%的显著优势在非特定人识别与未见语句识别两个任务中均获得冠军。

ICCV 2025 MSLR竞赛 团队获奖证书

陈熙霖、闵越聪团队长期深耕于手语识别与手语翻译领域。今年早些时候,该团队(成员包括:彭钰婷、焦培淇和邹鸿刚)还在WWW 2025 跨视角手语孤立词识别竞赛(Cross-View Isolated Sign Language Recognition,CV-ISLR)中同样取得冠军的佳绩。该竞赛旨在关注多视角场景下的手语识别问题。WWW2025竞赛评测涵盖了实验室场景、自然场景、合成背景与时序扰动四个子集,并设置了基于RGB与RGB-D模态输入的两个任务。该团队通过跨视角数据增强与多模态融合等关键技术,有效提升了模型在未见视角下的识别性能,获得了RGB与RGB-D两个任务的冠军。

WWW 2025 CV-ISLR竞赛 团队获奖证书

陈熙霖、闵越聪团队长期从事手语识别与翻译相关领域研究,致力于推动人工智能技术在无障碍交流与人机交互中的应用落地。团队围绕视觉表征建模、多模态融合、跨视角泛化与语义理解等关键技术问题为核心研究方向,积极推动手语识别技术从实验室走向实际应用,助力听障群体与健听人群之间的自然交流。